- 入门教程

- ANN教程

- CNN教程

- RNN教程

关注我们

梯度下降优化被认为是数据科学中的重要概念,考虑以下所示的步骤,以了解梯度下降优化的实现-

第1步 - 包括必要的模块以及x和y变量的声明,通过它们无涯教程将定义梯度下降优化。

import tensorflow as tf x = tf.Variable(2, name = 'x', dtype = tf.float32) log_x = tf.log(x) log_x_squared = tf.square(log_x) optimizer = tf.train.GradientDescentOptimizer(0.5) train = optimizer.minimize(log_x_squared)

第2步 - 初始化必要的变量,并调用优化器以使用相应的函数进行定义和调用。

init = tf.initialize_all_variables() def optimize(): with tf.Session() as session: session.run(init) print("starting at", "x:", session.run(x), "log(x)^2:", session.run(log_x_squared)) for step in range(10): session.run(train) print("step", step, "x:", session.run(x), "log(x)^2:", session.run(log_x_squared)) optimize()

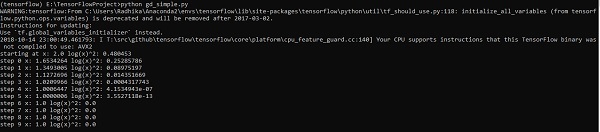

上面的代码行生成输出,如下面的屏幕快照所示-

祝学习愉快!(内容编辑有误?请选中要编辑内容 -> 右键 -> 修改 -> 提交!)

Tony Bai · Go语言第一课 -〔Tony Bai〕

好记忆不如烂笔头。留下您的足迹吧 :)

《TensorFlow入门教程》

《TensorFlow入门教程》